Le rapport annuel de 2023 montre l’impact du Conseil sur Meta

27 juin 2024

2023 a été une année placée sous le signe de l’innovation et de l’impact pour le Conseil. Nos recommandations ont contribué à améliorer davantage l’expérience des utilisateurs sur les plateformes de Meta et, en publiant plus de décisions dans de nouveaux formats, nous avons pu aborder un plus grand nombre de questions difficiles en matière de modération de contenu.

L’application de nos recommandations par Meta atteint un nouveau pic. Notre rapport annuel de 2023 montre qu’entre janvier 2021, lors de la publication de nos premières décisions, et mai 2024, lors de la finalisation de ce rapport, Meta avait partiellement ou intégralement mis en œuvre 75 de nos recommandations, et avait signalé que 81 autres recommandations étaient en cours de mise en œuvre. Les chiffres, bien sûr, ne constituent qu’une vue partielle de la situation : la qualité et l’impact des recommandations sont les critères prioritaires.

Obtenir des résultats pour les utilisateurs Facebook et Instagram

Un problème récurrent est la confusion des utilisateurs quant au motif des décisions de suppression de contenu ou de suspension de compte par Meta.

Pour y remédier, nous avons exhorté Meta à respecter certains principes en matière de transparence : faciliter la compréhension des règles ; expliquer aux gens aussi clairement que possible comment vous prenez et appliquez vos décisions ; et, lorsque les gens enfreignent vos règles, indiquer le motif exact.

En 2022, en réponse à nos recommandations, Meta a mis en place de nouvelles communications indiquant aux utilisateurs la politique spécifique qu’ils ont enfreinte dans le cadre des politiques relatives aux discours incitant à la haine, aux individus et organisations dangereux, ainsi qu’à l’intimidation et au harcèlement.

En 2023, nos recommandations ont amélioré encore davantage l’expérience des utilisateurs de Facebook et d’Instagram.

Le rapport annuel actuel démontre la façon dont, à la suite des recommandations du Conseil, Meta a :

- Lancé le « Statut du compte », une expérience intégrée qui fournit des informations aux utilisateurs sur les sanctions actuelles et passées appliquées à leur compte par Meta, ainsi que le motif qui les justifie.

- Amélioré son système de sanctions de façon à expliquer les raisons de la suppression d’un contenu ainsi que le fonctionnement du système et à rendre ce dernier plus équitable pour les utilisateurs qui en ont fait les frais de manière disproportionnée par le passé.

- Commencé à envoyer des avertissements de potentielles violations de politiques aux utilisateurs publiant des publications susceptibles d’être concernés, leur donnant ainsi l’occasion de modifier et de republier leur contenu afin qu’il soit conforme. Sur une période de 12 semaines en 2023, Meta a émis des avertissements concernant plus de 100 millions de contenus distincts*.

Nous avons perpétué cette dynamique en 2024, nos recommandations améliorant encore davantage l’expérience des utilisateurs des plateformes de Meta.

Les utilisateurs nous disent souvent que Meta a supprimé des publications appelant l’attention du public sur des discours incitant à la haine afin de condamner ces derniers, de sensibiliser ou de les discréditer, et ce, en raison de l’incapacité des systèmes automatisés (et parfois même des examinateurs humains) à distinguer un discours incitant à la haine et une publication qui le condamne. Pour traiter cette problématique, nous avons demandé à Meta de créer un moyen facile d’indiquer dans les appels effectués par les utilisateurs qu’une publication entrait dans l’une de ces catégories. Meta a souscrit à notre demande et nous partageons, aujourd’hui, de nouvelles données concernant l’impact de cette mesure.

- En février 2024, Meta a reçu plus de sept millions d’appels de la part d’utilisateurs dont les contenus avaient été supprimés conformément aux règles de l’entreprise concernant les discours incitant à la haine. 8 utilisateurs sur 10 à l’origine des appels ont opté pour cette nouvelle option permettant de fournir davantage de contexte. 1 sur 5 a indiqué que son contenu visait à sensibiliser son audience sur un sujet, tandis que 1 sur 3 a affirmé qu’il s’agissait d’une plaisanterie. Nous pensons qu’offrir aux gens la possibilité de s’exprimer et les écouter peut aider à mieux informer les prises de décision de Meta*.

- En mai 2024, en réponse à nos recommandations, Meta a commencé à apposer sur les contenus audio, vidéo, ainsi que sur les photos, une mention indiquant l’utilisation de l’IA. Les utilisateurs bénéficient ainsi d’une plus grande transparence et de davantage de contexte en ce qui a trait à la manipulation de publications dans un plus grand nombre de formats, et les publications qui enfreignent les règles de Meta de toute autre manière seront supprimées.

Protection et préservation du discours politique

Nos recommandations ont également aidé Meta à préserver et à protéger des contenus concernant des conditions sanitaires, des manifestations et des atrocités commises en temps de conflit.

Notre rapport annuel de 2023 démontre la façon dont, à la suite des recommandations du Conseil, Meta :

- A autorisé la diffusion de l’expression « Marg bar Khamenei » (qui se traduit littéralement par « Mort à Khamenei [le guide suprême de l’Iran] ») dans le contexte des manifestations en Iran. Après que cette recommandation a été mise en œuvre en janvier 2023, l’analyse d’un échantillon de comptes Instagram a montré que le nombre de publications utilisant ce terme avait augmenté de près de 30 % , Meta protégeant ainsi la liberté du discours politique en Iran.

- A mis à jour et créé des classifications qui, sur deux périodes de 30 jours en 2023, ont empêché la suppression automatique d’un total de 3 500 publications sur le cancer du sein. Cela permet de protéger des contenus cruciaux concernant les populations atteintes du cancer du sein et les structures faisant campagne à ce sujet.

- Finalise actuellement une nouvelle approche cohérente de conservation de potentielles preuves d’atrocités et de violations sérieuses des lois internationales en matière de droits humains et de droit humanitaire.

Publier de nouveaux cas, plus rapidement

2023 a également été une année d’innovation et d’impact pour le Conseil. À la suite de notre engagement à publier davantage de cas et plus rapidement, nous avons publié nos premières décisions sommaires qui examinent les cas pour lesquels Meta est revenu sur sa décision initiale lorsqu’un contenu a été sélectionné dans le cadre d’une éventuelle révision. Nous avons également émis nos premières décisions accélérées concernant le conflit entre Israël et le Hamas.

Nous avons, par ailleurs, publié des décisions standard relatives à de nouveaux sujets tels que les prisonniers de guerre, les régimes alimentaires extrêmes ainsi que les discours violents à l’attention des personnes transgenres. Au total, nous avons émis plus de 53 décisions en 2023, bien plus que pour les années précédentes, et, dans près de 90 % des cas, celles-ci étaient contraires à la décision initiale de Meta.

Avec 47 cas à l’heure actuelle en 2024, nous pourrions bien dépasser les chiffres de l’année passée. Ces cas représentent des sujets cruciaux en matière de modération de contenus, tels que les mésinformations générées par l’IA, le négationnisme et la critique de chefs d’État.

En février, nous avons aussi étendu notre périmètre d’action pour inclure Threads. C’est la première fois que nous incluons une nouvelle application. Le premier cas Threads a été ouvert en mai. Nous avons constaté une implication plus importante envers notre travail, 2 800 commentaires publics ayant été envoyés pour des cas publiés ou annoncés cette année, soit le double des chiffres enregistrés et accumulés sur deux années, en 2022 et en 2023.

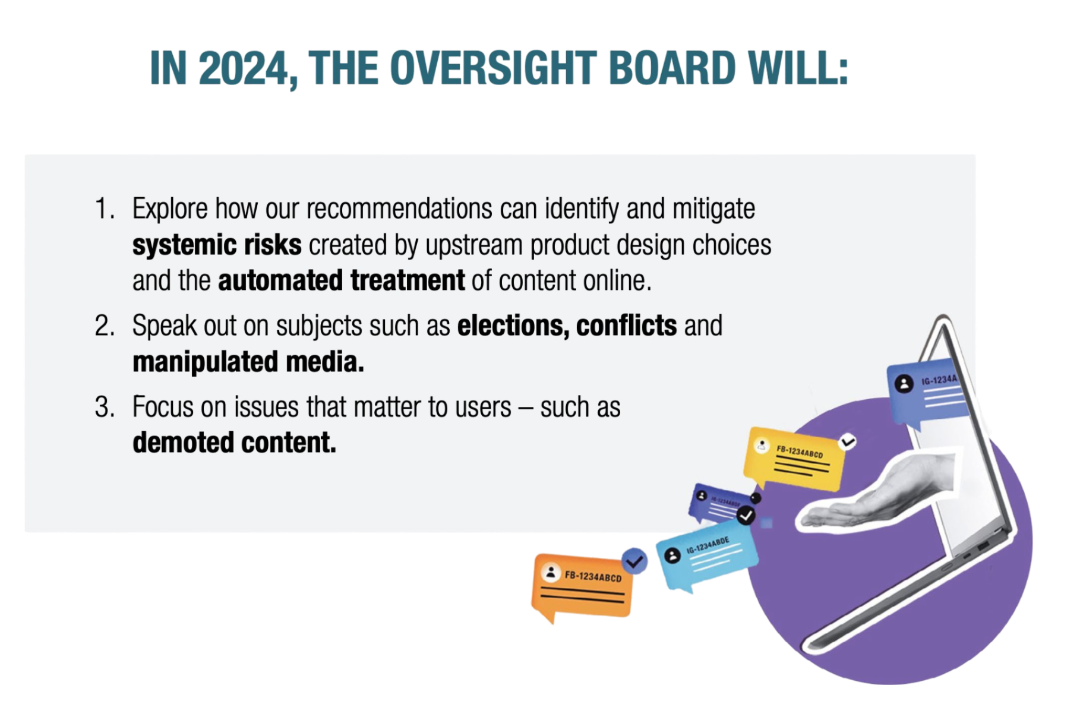

Développement de notre périmètre

Si nous avons déjà fourni un travail conséquent pour nous améliorer, nous innovons désormais nos processus afin de nous aligner avec les grandes questions actuelles en matière de modération de contenus. En 2024, par exemple, nous publions des livres blancs étudiant des problématiques rencontrées par le Conseil concernant les réseaux sociaux, à partir de l’expérience de toute notre structure, plutôt que sur la base de certains cas spécifiques.

La moitié de la population mondiale se rendant aux urnes cette année, nous avons publié notre premier livre blanc sur les élections, qui comprenait 9 conclusions clés destinées aux professionnels. Dans les semaines à venir, nous publierons un prochain livre blanc sur l’automatisation et l’IA.

Par la suite, courant 2024, nous traiterons d’autres problématiques majeures pour nos utilisateurs, telles que les contenus pénalisés, mais non supprimés. Nous sommes également attentifs à la conjoncture réglementaire en constante évolution et à l’importance du modèle du Conseil : un corps de délibération indépendant à l’échelle mondiale qui évalue des cas sous le prisme des droits humains, et aide à corriger le tir en toute transparence.

Récemment, dans le cadre de notre travail d’amélioration de l’expérience utilisateur, nous avons rendu nos procédures d’appel plus intuitives, en collaboration avec Meta. En sus, dans le sillage du lancement de notre nouveau site web en mai, nous apportons des changements aux rapports de transparence. Notre nouveau site web inclut désormais une grande partie du contenu publié dans nos rapports de transparence trimestriels, et plus récemment semestriels, y compris un dispositif de suivi interactif pour nos recommandations, une archive de commentaires publics et la possibilité de filtrer les décisions par pays, par région et par standard de communauté. Dans cette optique, nous continuerons à publier des rapports annuels, et non plus des rapports semestriels.

Bien que né voilà seulement 4 ans, le Conseil continue à aborder quelques-unes des questions les plus problématiques en matière de modération de contenu et exhorte Meta à interagir avec les utilisateurs de la façon la plus équitable possible. Le défi est de taille, l’incertitude est considérable, mais notre travail est crucial. Ensemble, nous chercherons à trouver des réponses qui amélioreront l’environnement des réseaux sociaux dans le monde entier.

Pour plus d’informations sur nos rapports de transparence, cliquez ici.

* Attention : Toutes les informations sont agrégées et anonymisées pour la protection de la confidentialité des utilisateurs. Toutes les mesures sont des estimations fondées sur les informations disponibles à un instant donné.